素数定理の証明については、ザギエ(Zagier)による4ページの解説論文「Newman's Short Proof of the Prime Number Theorem」に示されている証明があるけど、説明が簡潔すぎることもあって証明を読み進んでいくのがかなり大変という印象がある。

むしろ、アダマールとド・ラ・ヴァレ・プーサンによる素数定理の最初の証明の方が、きちんと正しく証明するのは非常に難しいにしても、やりたい事は分かりやすい気がする。

またザギエが参照しているコレヴァ(Korevaar)の解説論文を見てみると、ザギエの提示している証明の背後には、ウィーナー・池原の定理による証明が存在していることが分かる。*1

なので、その辺りのことをまとめておく。

目次:

1. チェビシェフ関数の性質

1.1. 第1チェビシェフ関数θ(x)、第2チェビシェフ関数ψ(x)

アダマールやド・ラ・ヴァレ・プーサンによる証明も、ウィーナー・池原の定理を用いる証明も、ザギエの証明も、いずれもチェビシェフ関数を利用しているので、その説明からおこなう。(ちなみにニューマンの論文では素数定理の証明を2つ示しているけれど、どちらもチェビシェフ関数を使うのとは別の経路で素数定理を証明している。)

第1チェビシェフ関数θ(x)は、

と定義される。これは、

のように書くこともできる。(和の添字にpを使ったときは、pは素数だけを渡るとする)。

例えばθ(10)を考える。10より小さい素数は、2、3、5、7、なので、

となる。

一方、第2チェビシェフ関数ψ(x)は、x以下の素数だけでなく、x以下の数で「素数のべき乗になる数 pm」に対しても、log p を足す。これは、

と書くこともできる。(ここでpは素数、mは正整数を動く。)

例えば ψ(10)を考えると、10より小さい数で、素数、または、素数のべき乗になっている数は、

なので、

となり、θ(10)と比べると、4、8、9に対するlog2、 log2、log3のぶんだけだけ大きくなっている。

1.2. チェビシェフ関数と素数定理

さて、素数定理の証明の観点から重要なのは、

あるいは、

が成り立てば、そこから素数定理

が導かれる、ということ。(ここで f(x)~g(x) は、を表す。)

実際、アダマールとド・ラ・ヴァレ・プーサンは、第2チェビシェフ関数ψ(x)について ψ(x)~x を示すことで素数定理を証明した。

1.3. チェビシェフ関数とゼータ関数の関係

素数定理の証明では、ゼータ関数の性質が重要な役割を果たす。

まず第2チェビシェフ関数ψ(x)とゼータ関数ζ(s)の間には、

の関係がある。アダマールとド・ラ・ヴァレ・プーサンによる素数定理証明はフォン・マンゴルトの明示公式にもとづいたものだけど、その明示公式はこの関係式から出発して導かれる。またウィーナー・池原の定理を用いる証明では、この関係式にウィーナー・池原の定理を適用する。

一方、第1チェビシェフ関数θ(x)とゼータ関数の関係はもう少しだけ複雑で、同様の形の変換をほどこすと、-ζ'(s)/ζ(s)の代わりに というディリクレ級数(ここで和の添字pは全ての素数を渡る)で定義される関数に変換され、

という関係になっている。ザギエの証明は、第2チェビシェフ関数ではなく、第1チェビシェフ関数を使っているので、そのぶん素数定理とゼータ関数との関係は少し分かりにくくなっているような感じがする。

2. フォン・マンゴルトの明示公式と、アダマールとド・ラ・ヴァレ・プーサンによる証明

アダマールとド・ラ・ヴァレ・プーサンによる素数定理の証明では、チェビシェフ関数に対するフォン・マンゴルトの明示公式が重要な役割を果たしている。(フォン・マンゴルトが明示公式を証明したのが1895年。アダマールとド・ラ・ヴァレ・プーサンがそれぞれ独立に素数定理を証明したのが1896年)

導出過程などは略して明示公式を示すと、第2チェビシェフ関数ψ(x)(を不連続点で少し修正した関数)が、フォン・マルゴントの明示公式では

のように表される。ここで和の「ρ」は ゼータ関数ζ(s)の0≦Re(s)≦1の範囲にある全ての零点を渡る。

素数定理を示すには「ψ(x)~x」すなわち を示せば良かったけど、明示公式のうちゼータ関数の零点についての和以外の部分を見ると、

となっている。なので、あとは

が言えれば、素数定理が証明できたことになる。

ここで、ゼータ関数の零点ρ=a+ibを適当に一つ取って、

の値を考える。xは実数で、実数の虚数乗は絶対値が1だから、xibの部分は絶対値が1。なので、もしもρの実部Re(ρ)=a<1 ならば、 となる。

ということは、あとは 0≦Re(s)≦1の範囲にある全ての零点ρがRe(ρ)<1であることが言えれば(そのためにはRe(s)=1でζ(s)≠0となることが言えればいい)素数定理が証明される?

残念ながらこれは成り立たない。0≦Re(s)≦1の範囲にあるゼータ関数の零点は無限個あり、しかも は条件収束しかしていないので、各項をxで割ったものが0に収束することが言えても、和全体をxで割ったものが0に収束することは言えない。

とはいえ、アダマールもド・ラ・ヴァレ・プーサンも、和の極限に関するこの問題をうまく回避し、なおかつRe(s)=1でζ(s)≠0 となることも証明して、素数定理を証明することに成功した。

3. ウィーナー・池原の定理による証明

3.1. メリン変換

アダマールもド・ラ・ヴァレ・プーサンも、フォン・マルゴントの明示公式(を和の極限の困難をさけるために修正したもの)を使って素数定理を証明している。しかし、導出過程をきちんと正当化しつつ明示公式を導くのは非常にたいへん。

なので明示公式を使わない証明があるとうれしい。

そこでまず、明示公式に至る前の 、あるいは

の形の積分

について調べてみる。これはメリン変換と呼ばれる形の積分。(1/xを新しい変数にして変数変換して積分範囲も変えると、「メリン変換」で通常提示される形になる。)

まず f(x) = cx として、メリン変換 g(s) を計算してみると、

となる。またここで積分の下端1を別の値にしてみると、

となっている。積分の下端Aをどれだけ大きな数にしてもこうなるのて、xが大きい部分での積分結果が の部分に集約されているように見える。

次にf(x)として、f(x)~cxであるような任意の関数f(x)を取ってみる。するとこの場合もRe(s)>1で積分できて、右側からs=1に近づいていくと、 となる。(つまりs→1のとき g(s)≒

のように振舞う。)

例えば、f(x) = ⌊x⌋ (= x以下の最大整数)とすると、f(x)~x で、で、ζ(s)はs=1に留数1の1位の極を持つのでs→1でζ(s)≒

が成り立っている。

では逆に「s→1のときに g(s)≒ のように振舞うなら f(x)~cx」が言えるか?

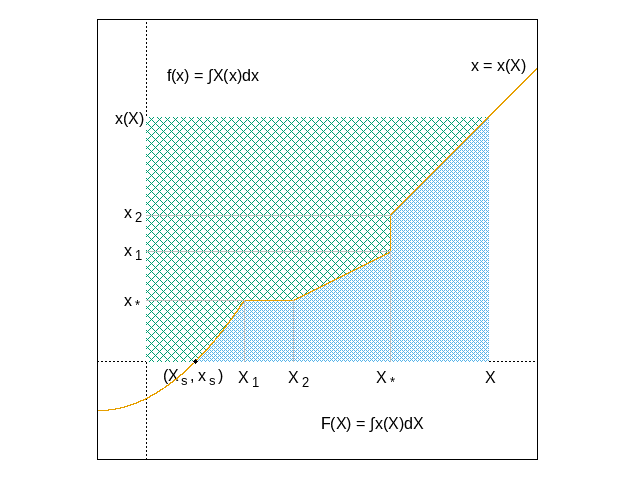

というとこれは成り立たない。例えば、

という関数を考える。これはy=xのグラフとy=2xのグラフの間を階段状に増加していく関数なので、特定のcxには漸近しない。しかし、このf(x)からg(s)を計算すると、

となり、s→1のとき、 のように振舞う(はず。計算ミスがなければ。)

とはいえ、 が、s→1で g(s)≒

のように振舞うことと、なんらかの補助的な条件から、f(x)~cx を導けないだろうか。

それを助けてくれるのが、ウィーナー・池原の定理。

3.2. ウィーナー・池原の定理

ウィーナー・池原の定理を、ここでの話に合わせた形で提示すると、次のようになる。

ウィーナー・池原の定理

f(x)は、x≧1で非負かつ非減少な関数であり、そのメリン変換

は、Re(s)>1で存在するとする。このとき、関数

を Re(s)≧1 の範囲に連続関数として拡張できるなら、

が成り立つ。(つまり f(x)~cx が成り立つ。)

例えば、f(x)として先に例として出したy=xとy=2xの間を階段状に増加する関数(cxに漸近しない関数)を取ると、 だったので、境界線Re(s)=1に右から近づいたとき、s→1だけでなく、

の時にも発散するため、ウィーナー・池原の定理の条件「

を Re(s)≧1 の範囲に連続関数として拡張できる」を満たすことができない。

3.3. ウィーナー・池原の定理を用いた素数定理の証明

ウィーナー・池原の定理を素数定理の証明に適用するためには、メリン変換

が必要な性質を満たしていることを見る必要がある。

まずRe(s)>1の範囲でが値を持つ必要がある。(例えばf(x)=x2だと、Re(s)>2でないと積分が発散する。)

これを言うには「ψ(x) = O(x)」(ψ(x)の増加が、xの定数倍より遅い)を証明すればいい。

あとは、の、Re(s)=1上での様子(連続かどうか)が問題となる。

ζ(s)が零点か極になるsでは、-ζ'(s)/ζ(s)は極を持ち、それ以外の点では-ζ'(s)/ζ(s)は正則になることに注意して考える。(ここで、素数定理の最初の証明で示された「Re(s)=1でζ(s)≠0」が使われる。)

まずゼータ関数ζ(s)の極を見る。ζ(s)はs=1に1位の極を持っていて、とローラン展開される。このことから、

となって -ζ'(s)/ζ(s)もs=1で留数1の1位の極を持つことが分かる。

これでs=1のことが分かったので、Re(s)=1の直線上のs=1以外の点での -ζ'(s)/ζ(s) の様子が問題となる。素数定理の最初の証明で示されたように、Re(s)=1ではζ(s)≠0だった(そしてζ(s)はs=1以外には極を持たない)。なので、-ζ'(s)/ζ(s)はRe(s)=1の直線上でs=1を除いて正則になる。よっては、Re(s)=1の直線上全体で正則となるので、Re(s)=1上で連続。

こうして、ζ(s)がRe(s)=1でζ(s)≠0であること(とs=1で極を持つこと)から、ψ(x)と -ζ'(s)/ζ(s) がウィーナー・池原の定理の適用条件を満たしていることが導かれる。

したがってウィーナー・池原の定理を適用することで、ψ(x)~xが言え、素数定理が証明される。

4. ニューマンの証明

4.1. コレヴァの証明

ニューマンは、コーシーの積分定理をうまく用いて補助的な定理を証明し、それを使って素数定理の証明を大幅に簡略化した。

しかしニューマン自身の証明は、チェビシェフ関数を使うのとは異なる仕方の証明なので、ここではニューマンの証明を分析したコレヴァによる証明を見る。

まずコレヴァは、ニューマンが用いた手法によって次の補助定理が証明できることから始める。(この補助定理はザギエの証明でも使われる。コレヴァの論文では「Auxiliary Tauberian theorem」と呼ばれ、ザギエの論文では「Analytic Theorem」と呼ばれている。)

定理: 関数F(t) (t≧0) は有界で、任意の有界閉区間で積分できるとする。このとき

は、Re(z)>0で正則。

このG(z)がRe(z)≧0まで解析接続できるとする。

このとき、は収束し、

が成り立つ。

コレヴァは次に、この定理から、弱い形のウィーナー・池原の定理を導く。「弱い」というのは、定理の適用条件が元の定理より厳しくなっているからで、元の定理で「Re(s)≧1まで連続関数として拡張できる」という条件だったところが、「Re(s)=1上の各点の近傍まで解析接続できる」になる。

しかし、-ζ'(s)/ζ(s) はこちらの条件も満たしているので、弱いウィーナー・池原の定理を適用できて、それにより素数定理が証明される。

これがコレヴァによる証明の道筋。

4.2. ザギエの証明での変更点

ザギエが解説論文で示している証明は、コレヴァの証明をいくらか修正したものになっている。

まず一点目として、ザギエは第2チェビシェフ関数ψ(x)ではなく第1チェビシェフ関数θ(x)を使って証明をおこなっている。

これは、第1チェビシェフ関数のメリン変換

にもウィーナー・池原の定理が適用できるため。 で、

の部分は、Re(z)=1を含む適当な範囲で正則なため、定理の適用条件には影響を与えないので。

二点目として、コレヴァのように補助定理から弱いウィーナー・池原の定理を一般的に導くのではなく、それを導く過程に対して直接第1チェビシェフ関数θ(x)を適用して、θ(x)~x を示している。

コレヴァは一般的な と

に補助定理を適用して、そこから f(x)~cx が成り立つことを示し、

に対する弱いウィーナー・池原の定理を証明する。

ザギエは、一般的なf(x)ではなく、 と

に補助定理を直接適用し、その結果を使ってθ(x)~xを証明する。

4.3. ザギエの証明でやらないといけないこと

最終的に、ザギエによる証明では、何を行う必要があるのか?

- [1] 補助定理の証明

ニューマンの手法によってコーシーの積分定理を使って補助定理を証明する、というのがコレヴァ・ザギエの証明のキーポイントになる。

次に、 と

が補助定理の条件を満たしている事を示さないといけない。(以下の[2]~[5])。

まず、が有界でないといけない。(この条件はウィーナー・池原の定理での「メリン変換がRe(s)>1で存在する」に対応する。) それを示すために「θ(x) = O(x)」の証明がいる。

- [2] θ(x) = O(x) (ザギエ 定理III)

そして、 がRe(z)≧0で正則であることを示さないといけない。

となるので、

がRe(s)≧1で正則であること(これは弱いウィーナー・池原の定理の適用条件にほかならない)を証明すればよい。

なので、本質的にはゼータ関数ζ(s)の性質を証明することになる。

まずζ(s)がs=1で留数1の1位の極を持ち、その点を除けば、Re(s)≧1を含む適当な領域で、ζ(s)が正則になる、という性質の証明をする。

あとは、Re(s)≧1でζ(s)≠0となることが言えれば、 がRe(s)≧1で正則であることが言え、そこから

もRe(s)≧1で正則であることが言える。

- [5] Re(s)≧1で、ζ(s)≠0かつ

は正則である。 (ザギエ 定理IV)

これでG(z)がRe(s)≧0で正則になることが言え、補助定理が適用でき、

が有限値に収束することが証明される。

- [6]

は収束する。 (ザギエ 定理V)

θ(x)~x というのは と等しいけど、これが

が収束することから導かれる。

- [7] θ(x)~x (ザギエ 定理VI)

そしてθ(x)~xから素数定理が導かれる。

ザギエは、以上の補助定理と定理I~VIの証明、素数定理の解説を4ページにまとめて提示している。

5. 参考文献

- D. J. Newman, Simple Analytic Proof of the Prime Number Theorem(1980)

- J. Korevaar, On Newman's Quick Way to the Prime Number Theorem(1982)

- D. Zagier, Newman's Short Proof of the Prime Number Theorem(1997)

- 河田敬義『数論―古典数論から類体論へ』岩波書店(1992)

- INTEGERS「素数定理の証明」

*1:ザギエの論文のタイトルは「Newman's Short Proof of the Prime Number Theorem」だけど、ニューマン自身の証明とはかなり違っていて、むしろコレヴァの解説論文「On Newman's Quick Way to the Prime Number Theorem」の証明を元にしている。